Testes de Hipóteses para Cientistas de Dados

No universo da Ciência de Dados, a habilidade de ir além da mera descrição e predição é crucial para extrair valor real dos dados. Os Testes de Hipóteses são uma ferramenta fundamental da inferência estatística que permite aos cientistas de dados tomar decisões baseadas em evidências, avaliando a validade de uma afirmação ou a existência de um efeito. Este artigo explora os princípios centrais dos testes de hipóteses, desde a formulação da hipótese nula e alternativa até a interpretação do p-valor e a compreensão dos erros tipo I e tipo II. Discute-se a importância da seleção do teste adequado, o conceito de significância estatística, o papel do poder estatístico e do tamanho do efeito, e suas aplicações práticas em cenários como A/B testing, validação de modelos e análise de políticas. São abordados os desafios comuns e as considerações éticas, enfatizando a necessidade de um pensamento crítico para evitar conclusões enganosas e garantir a robustez das decisões orientadas por dados.

1. Introdução

A Ciência de Dados é uma disciplina que integra estatística, computação e conhecimento de domínio para extrair insights e valor de grandes volumes de dados. Enquanto o Machine Learning se concentra em construir modelos preditivos e descritivos, a inferência estatística — e, em particular, os Testes de Hipóteses — capacita os cientistas de dados a fazer afirmações mais rigorosas sobre os fenômenos subjacentes aos dados. É a ponte entre a observação e a conclusão baseada em evidências.

Imagine que uma empresa de e-commerce implementou um novo design para sua página de checkout e deseja saber se ele realmente aumentou as conversões. Ou que um pesquisador de saúde quer determinar se um novo medicamento é mais eficaz que um placebo. Em ambos os cenários, não é suficiente apenas observar uma diferença; é preciso determinar se essa diferença é estatisticamente significativa ou se poderia ter ocorrido puramente por acaso.

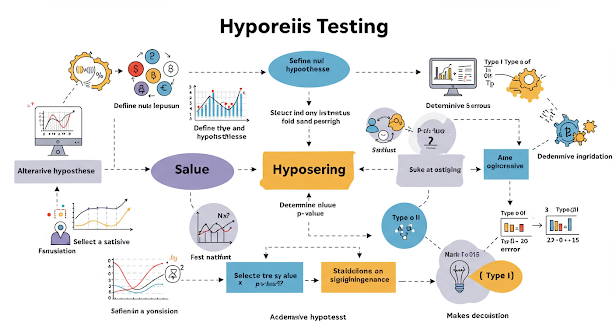

2. Fundamentos dos Testes de Hipóteses

Um teste de hipóteses é um procedimento estatístico para tomar uma decisão entre duas hipóteses concorrentes sobre um parâmetro populacional, usando dados de uma amostra.

2.1. Hipótese Nula (H0) e Hipótese Alternativa (H1 ou HA)

Todo teste de hipóteses começa com a formulação de duas declarações opostas:

Hipótese Nula (): Representa a posição padrão, o status quo, ou a ausência de um efeito ou diferença. É a hipótese que assumimos ser verdadeira até que haja evidência estatística suficiente para rejeitá-la. Ex: "Não há diferença no tempo médio de carregamento do site entre o design antigo e o novo." ou "O novo medicamento não tem efeito na redução da pressão arterial."

Hipótese Alternativa ( ou ): Representa o que o pesquisador ou cientista de dados tenta provar. É a afirmação que esperamos que os dados apoiem. Ex: "O novo design do site resultou em um tempo médio de carregamento diferente." (teste bicaudal) ou "O novo medicamento reduz a pressão arterial." (teste unicaudal).

2.2. Nível de Significância (α)

O nível de significância (), também conhecido como nível de erro tipo I, é a probabilidade máxima de rejeitar a hipótese nula quando ela é, de fato, verdadeira. É um limite predefinido pelo pesquisador, tipicamente 0.05 (5%), mas pode ser 0.01 (1%) para estudos mais rigorosos, ou 0.10 (10%) para estudos exploratórios. Um significa que estamos dispostos a aceitar uma chance de 5% de cometer um erro tipo I.

2.3. Estatística de Teste e Distribuição Amostral

Com base na hipótese nula e nos dados da amostra, calcula-se uma estatística de teste (ex: valor t, valor Z, valor F, valor χ2). Essa estatística quantifica o quão longe a amostra observada está do que seria esperado sob a hipótese nula. Para interpretar essa estatística, ela é comparada com uma distribuição amostral teórica que se sabe seguir se a H0 for verdadeira (ex: distribuição t de Student, distribuição normal padrão).

2.4. P-valor

O p-valor (valor de probabilidade) é a probabilidade de observar uma estatística de teste tão extrema ou mais extrema do que a que foi realmente observada, assumindo que a hipótese nula é verdadeira.

P-valor baixo (): Se o p-valor é menor que o nível de significância (α), a evidência contra a hipótese nula é considerada forte o suficiente para rejeitar H0. Isso não significa que H0 é falsa, mas que os dados observados são improváveis de ocorrer se H0 fosse verdadeira.

P-valor alto (): Se o p-valor é maior ou igual ao nível de significância, a evidência contra a hipótese nula não é considerada forte o suficiente para rejeitá-la. Isso não significa que H0 é verdadeira, apenas que não temos dados suficientes para refutá-la no nível de α escolhido.

2.5. Erros em Testes de Hipóteses

Existem dois tipos de erros que podem ser cometidos em um teste de hipóteses:

Erro Tipo I (): Rejeitar a hipótese nula quando ela é, de fato, verdadeira (falso positivo). Ex: Concluir que o novo design do site aumentou as conversões, quando na verdade não houve efeito. O risco de cometer um erro Tipo I é diretamente controlado pelo nível de significância α.

Erro Tipo II (): Não rejeitar a hipótese nula quando ela é, de fato, falsa (falso negativo). Ex: Não detectar um aumento real nas conversões causado pelo novo design do site.

2.6. Poder Estatístico (1 - β)

O poder estatístico de um teste é a probabilidade de rejeitar corretamente a hipótese nula quando ela é, de fato, falsa. É a capacidade do teste de detectar um efeito real (verdadeiro positivo). Um alto poder estatístico é desejável. O poder é influenciado por:

Tamanho do Efeito: A magnitude da diferença ou relação que se deseja detectar. Efeitos maiores são mais fáceis de detectar.

Tamanho da Amostra: Amostras maiores geralmente aumentam o poder do teste, pois fornecem mais informações e reduzem a variância.

Nível de Significância (): Aumentar α aumenta o poder (mas também aumenta o erro Tipo I).

Variabilidade dos Dados: Menor variabilidade nos dados aumenta o poder.

3. Tipos Comuns de Testes de Hipóteses para Cientistas de Dados

A escolha do teste estatístico depende do tipo de dados (contínuos, categóricos), do número de amostras, da sua distribuição e da pergunta de pesquisa.

Testes para Comparação de Médias:

Teste t de Student: Usado para comparar médias de duas amostras (amostras independentes ou pareadas) quando os dados são normalmente distribuídos e a variância da população é desconhecida. Exemplos: Testar se um grupo de tratamento tem uma média diferente de um grupo de controle.

ANOVA (Análise de Variância): Para comparar médias de três ou mais grupos. Ex: Comparar o desempenho de três versões diferentes de um algoritmo.

Testes para Comparação de Proporções:

Teste Z para Proporções: Comparar proporções de duas amostras (ex: comparar a taxa de cliques de dois banners diferentes).

Teste Qui-quadrado (): Para testar a associação entre duas variáveis categóricas (teste de independência) ou para verificar se as frequências observadas de uma categoria se ajustam às frequências esperadas (teste de aderência). Ex: Avaliar se há associação entre gênero e preferência por um produto.

Testes para Correlação:

Teste de Correlação de Pearson: Para testar a significância de uma correlação linear entre duas variáveis contínuas.

Teste de Correlação de Spearman/Kendall: Para relações não-lineares ou dados ordinais.

Testes Não Paramétricos: Usados quando as suposições sobre a distribuição dos dados (ex: normalidade) não são atendidas.

Teste de Wilcoxon-Mann-Whitney (U-test): Equivalente não paramétrico do teste t para amostras independentes.

Teste de Kruskal-Wallis: Equivalente não paramétrico da ANOVA.

Teste de Friedman: Equivalente não paramétrico da ANOVA de medidas repetidas.

4. Aplicações Práticas em Ciência de Dados

Os testes de hipóteses são onipresentes na Ciência de Dados:

A/B Testing (Testes A/B): A aplicação mais comum. Empresas usam testes A/B para comparar duas versões de uma página web, funcionalidade, e-mail de marketing, etc., para determinar qual delas tem melhor desempenho (ex: maior taxa de conversão, maior tempo de permanência). Os testes de hipóteses (tipicamente Z-test ou χ2) são usados para determinar se a diferença observada nas métricas é estatisticamente significativa e não apenas aleatória.

Validação de Modelos de Machine Learning:

Comparar o desempenho de dois modelos preditivos (ex: um novo modelo de classificação vs. um modelo baseline) em métricas como acurácia, F1-score, AUC. Testes de hipóteses podem determinar se um modelo é significativamente melhor que outro.

Testar se a diferença nas taxas de erro em conjuntos de dados específicos é significativa.

Análise de Políticas e Intervenções: Avaliar o impacto de novas políticas, programas ou mudanças em um sistema. Ex: Determinar se uma nova campanha de saúde pública realmente reduziu a incidência de uma doença.

Controle de Qualidade: Monitorar processos para garantir que eles permaneçam dentro de limites aceitáveis e detectar desvios significativos.

Análise Exploratória de Dados: Embora não seja o objetivo principal, testes de hipóteses podem auxiliar na identificação de relações potenciais entre variáveis que merecem exploração mais aprofundada.

Seleção de Características (Feature Selection): Testar a significância da relação entre uma característica e a variável alvo para decidir quais características incluir em um modelo preditivo.

5. Desafios e Armadilhas Comuns

A aplicação de testes de hipóteses não é trivial e exige um entendimento cuidadoso para evitar conclusões falhas.

P-hacking (Ou Fishing for Significance): Realizar múltiplos testes de hipóteses nos mesmos dados até encontrar um resultado "significativo" (p < α), sem correção para comparações múltiplas. Isso aumenta drasticamente a chance de um erro Tipo I.

Interpretação Incorreta do P-valor: Um p-valor baixo não prova que a hipótese alternativa é verdadeira, nem que a H0 é falsa, nem que o efeito é grande ou importante. Significa apenas que a probabilidade dos dados observados sob H0 é baixa. Um p-valor alto não prova que a H0 é verdadeira; pode significar que não há efeito ou que o teste não teve poder suficiente para detectá-lo.

Confundir Significância Estatística com Significância Prática: Uma diferença pode ser estatisticamente significativa (p-valor baixo) em grandes amostras, mesmo que a magnitude do efeito seja tão pequena que não tenha relevância prática ou econômica. O tamanho do efeito deve ser sempre considerado em conjunto com o p-valor.

Suposições dos Testes: A maioria dos testes paramétricos assume certas distribuições para os dados (ex: normalidade) ou igualdade de variâncias. Violar essas suposições pode invalidar os resultados do teste. É crucial verificar as suposições ou usar testes não paramétricos.

Tamanho da Amostra Insuficiente: Um tamanho de amostra pequeno pode levar a um baixo poder estatístico, aumentando o risco de um erro Tipo II (não detectar um efeito real). A análise de poder é importante antes de coletar dados.

Múltiplas Comparações: Ao realizar muitos testes de hipóteses simultaneamente, a probabilidade de encontrar um falso positivo por acaso aumenta. Métodos de correção como Bonferroni ou Holm-Bonferroni devem ser aplicados.

Viés de Publicação: A tendência de publicar apenas estudos com resultados estatisticamente significativos, levando a uma super-representação de falsos positivos na literatura.

6. Considerações Éticas e Boas Práticas

A responsabilidade do cientista de dados ao usar testes de hipóteses é grande, pois as conclusões podem impactar decisões críticas.

Transparência: Documentar claramente as hipóteses, métodos de coleta de dados, escolha do teste, nível de significância e todas as análises realizadas.

Reproducibilidade: Garantir que as análises possam ser replicadas por outros.

Reportar o Tamanho do Efeito e Intervalos de Confiança: Ir além do p-valor, quantificando a magnitude da diferença ou efeito e a incerteza associada à estimativa. Intervalos de confiança fornecem uma gama de valores plausíveis para o parâmetro populacional.

Planejamento Pré-análise: Definir as hipóteses, o nível de significância, o tamanho do efeito mínimo detectável e o tamanho da amostra necessário antes de coletar os dados.

Compreensão do Domínio: Conhecimento do contexto do negócio ou da pesquisa é crucial para formular hipóteses relevantes e interpretar os resultados corretamente.

Evitar a Caça ao P-valor: Resista à tentação de manipular dados ou testar diversas hipóteses até encontrar um resultado "significativo".

7. Conclusão

Os Testes de Hipóteses são uma ferramenta estatística indispensável no arsenal do cientista de dados. Eles fornecem uma estrutura rigorosa para converter observações de dados em conclusões baseadas em evidências, permitindo que as organizações tomem decisões mais informadas e estratégicas. Desde a otimização de produtos e serviços por meio de A/B testing até a validação da eficácia de intervenções e a robustez de modelos de Machine Learning, a capacidade de realizar e interpretar corretamente esses testes é fundamental.

No entanto, o poder dos testes de hipóteses vem acompanhado da responsabilidade de usá-los de forma adequada. A compreensão dos conceitos de hipótese nula e alternativa, p-valor, erros tipo I e tipo II, tamanho do efeito e poder estatístico é crucial para evitar armadilhas comuns e conclusões enganosas. Ao adotar boas práticas, como o planejamento pré-análise, a consideração do tamanho do efeito e a transparência, os cientistas de dados podem garantir que suas análises não apenas revelem insights, mas também forneçam uma base sólida e confiável para a ação em um mundo cada vez mais orientado por dados. Dominar os testes de hipóteses é essencial para transcender a mera análise descritiva e preditiva, capacitando a verdadeira inteligência de dados.

Referências (Exemplos - Você precisará pesquisar e adicionar referências reais e atuais)

[1] Montgomery, D. C. (2017). Design and Analysis of Experiments. John Wiley & Sons. (Clássico para design experimental e testes de hipóteses) [2] Cohen, J. (1988). Statistical Power Analysis for the Behavioral Sciences. Lawrence Erlbaum Associates. (Referência para poder estatístico e tamanho do efeito) [3] Wasserman, L. (2013). All of Statistics: A Concise Course in Statistical Inference. Springer. (Para fundamentos de inferência estatística) [4] Gelman, A., & Carlin, J. B. (2014). Beyond Power Calculations: Assessing Type S (Sign) and Type M (Magnitude) Errors. Perspectives on Psychological Science, 9(6), 641-651. (Discussão sobre p-valores e significância prática) [5] Koehler, J. A., et al. (2018). Introduction to Statistical Learning with Applications in R. Springer. (Aplicações de estatística em ML) [6] Box, G. E. P., Hunter, W. G., & Hunter, J. S. (2005). Statistics for Experimenters: Design, Innovation, and Discovery. John Wiley & Sons. [7] Kuhn, M., & Johnson, K. (2013). Applied Predictive Modeling. Springer. (Capítulos sobre avaliação de modelos e estatística) [8] Goodman, S. N. (2008). A Dirty Dozen: Twelve P-Value Misconceptions. Seminars in Hematology, 45(3), 135-140. (Excelente para entender as armadilhas do p-valor)