Apache Spark: Processamento Distribuído de Grandes Volumes de Dados

A era do Big Data transformou radicalmente a forma como as organizações e a pesquisa científica lidam com volumes massivos de informação. O processamento eficiente desses conjuntos de dados gigantescos tornou-se um desafio central, impulsionando o desenvolvimento de novas arquiteturas e frameworks. Entre as tecnologias mais proeminentes nesse cenário, o Apache Spark se destaca como um motor de processamento unificado e de código aberto, projetado para análises de dados em grande escala e em alta velocidade. Este artigo explora a arquitetura fundamental do Spark, seus componentes-chave e as inovações que o distinguem de outras plataformas, como o Hadoop MapReduce. Discute-se sua capacidade de processar dados em memória, sua versatilidade para diversas cargas de trabalho (batch, streaming, machine learning, SQL, grafos) e suas vastas aplicações em diferentes domínios. Também são abordados os desafios e as perspectivas futuras, enfatizando o papel do Spark como uma ferramenta indispensável para extrair valor de grandes volumes de dados.

1. Introdução

O fenômeno do Big Data — caracterizado pelos "três Vs" (Volume, Velocidade e Variedade) — representa um desafio e uma oportunidade sem precedentes para empresas, governos e a comunidade científica. A capacidade de coletar e armazenar trilhões de bytes de dados de diversas fontes, como sensores IoT, mídias sociais, transações financeiras e registros de saúde, superou a capacidade das ferramentas de processamento tradicionais. Sistemas legados, baseados em bancos de dados relacionais e servidores únicos, tornaram-se inadequados para lidar com a escala e a complexidade desses novos conjuntos de dados.

Historicamente, o Apache Hadoop e seu componente MapReduce foram pioneiros no processamento distribuído de Big Data. No entanto, o MapReduce, embora robusto para processamento em batch, apresentava limitações em termos de velocidade (devido ao uso extensivo de disco) e flexibilidade para cargas de trabalho interativas, em tempo real, ou iterativas (como Machine Learning).

É nesse cenário que o Apache Spark emergiu, oferecendo uma solução de processamento mais rápida, versátil e de uso mais amigável. Desenvolvido na Universidade da Califórnia, Berkeley, e depois doado à Apache Software Foundation, o Spark foi projetado para superar as deficiências do MapReduce, focando no processamento em memória e em um modelo de programação unificado. Desde então, ele se tornou a tecnologia dominante para análise de dados em grande escala, impulsionando avanços em áreas como inteligência artificial, personalização e saúde.

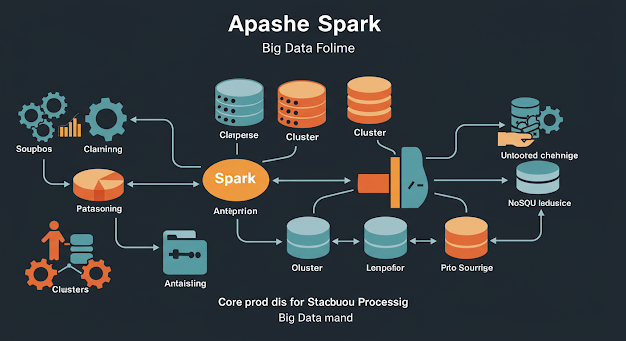

2. A Arquitetura Fundamental do Apache Spark

O Apache Spark é um motor de processamento distribuído de propósito geral que permite o processamento de dados em grande escala de forma rápida e eficiente. Sua arquitetura principal consiste em um driver program (que executa a função principal do programa e coordena as operações paralelas) e vários executores distribuídos em um cluster.

2.1. Componentes Chave

Spark Core: É o motor de execução subjacente para todas as outras bibliotecas do Spark. Ele fornece as funcionalidades básicas, como agendamento de tarefas, gerenciamento de memória e tolerância a falhas. O conceito central do Spark Core é o Resilient Distributed Dataset (RDD).

Resilient Distributed Datasets (RDDs): São coleções de elementos tolerantes a falhas, que podem ser operadas em paralelo. Os RDDs são a abstração fundamental do Spark para dados distribuídos. Eles são "resilientes" porque podem ser reconstruídos automaticamente em caso de falha de um nó no cluster, e são "distribuídos" porque seus dados são particionados e armazenados em diferentes nós. As operações em RDDs são divididas em:

Transformações: Operações que criam novos RDDs a partir de existentes (ex:

map,filter,join). São "lazy", ou seja, não são executadas imediatamente, mas sim construídas em um grafo de execução (DAG - Directed Acyclic Graph).Ações: Operações que disparam a execução das transformações e retornam um resultado ao driver (ex:

collect,count,saveAsTextFile).

Spark SQL: Permite o processamento de dados estruturados e semiestruturados usando consultas SQL ou API de DataFrames/Datasets. Os DataFrames são uma abstração de dados de alto nível que organiza os dados em colunas nomeadas, de forma semelhante a tabelas de banco de dados ou data frames no R/Python. Eles oferecem otimizações de desempenho significativas através do otimizador Catalyst e do gerador de código Tungsten, que juntos otimizam as consultas para serem executadas de forma mais eficiente.

DataFrames: Fornecem uma visão mais otimizada e fácil de usar para dados estruturados, com inferência de esquema e um modelo de programação mais declarativo.

Datasets: Extensão dos DataFrames que oferece segurança de tipo em tempo de compilação para linguagens como Scala e Java, combinando os benefícios dos RDDs (segurança de tipo) com as otimizações dos DataFrames.

Spark Streaming: Permite o processamento de dados em tempo real a partir de fontes como Kafka, Flume e HDFS. Ele utiliza o conceito de DStreams (Discretized Streams), que são sequências de RDDs, permitindo que as operações batch do Spark Core sejam aplicadas a fluxos de dados em mini-batches.

MLlib (Machine Learning Library): Uma biblioteca escalável de Machine Learning que oferece um conjunto rico de algoritmos de aprendizado (classificação, regressão, agrupamento, filtragem colaborativa) e ferramentas (extração de características, transformação) que podem ser executados em grandes conjuntos de dados de forma distribuída.

GraphX: Uma API para computação de grafos (redes) e análise de grafos paralela. Combina o processamento de grafos com as capacidades de ETL e ML do Spark, permitindo análises complexas em grandes grafos (ex: redes sociais, redes de tráfego).

2.2. Gerenciamento de Cluster

O Spark pode ser executado em vários gerenciadores de cluster, incluindo:

Standalone: Um gerenciador de cluster simples incluído no Spark.

Apache Mesos: Um framework de gerenciamento de recursos de cluster.

YARN (Yet Another Resource Negotiator): O gerenciador de recursos do Hadoop, sendo o mais comum para implantações de Spark em ambientes Hadoop.

Kubernetes: Uma plataforma de orquestração de contêineres, ganhando popularidade para o deploy de aplicações Spark.

3. As Inovações do Spark: Velocidade e Versatilidade

A principal inovação do Spark em relação ao MapReduce reside em sua capacidade de realizar processamento em memória e seu modelo de programação unificado.

3.1. Processamento em Memória

Ao contrário do MapReduce, que realiza operações intermediárias gravando dados no disco, o Spark mantém os dados em memória RAM sempre que possível. Isso permite que operações iterativas (como algoritmos de ML ou processamento de grafos, que precisam acessar os mesmos dados várias vezes) sejam executadas 10 a 100 vezes mais rápido do que com o MapReduce. Para operações em batch, o Spark ainda pode ser significativamente mais rápido (em torno de 10x) devido à otimização do DAG e à redução de I/O em disco.

3.2. Directed Acyclic Graph (DAG) Scheduler

O Spark otimiza o fluxo de trabalho de processamento através de um DAG Scheduler. Quando transformações são aplicadas a um RDD, o Spark constrói um grafo de execução que representa as dependências entre as operações. A execução só ocorre quando uma ação é chamada. Esse grafo permite que o Spark:

Otimize a Execução: Reordenar operações, combinar transformações e eliminar passos desnecessários.

Tolerância a Falhas: Se um nó falhar, o Spark pode recalcular apenas as partições perdidas, reexecutando as transformações necessárias a partir dos RDDs pai.

3.3. Modelo de Programação Unificado

A capacidade de lidar com diversas cargas de trabalho (batch, streaming, SQL, ML, grafos) sob uma única API e engine de execução é um diferencial do Spark. Isso simplifica o desenvolvimento e a manutenção de aplicações de Big Data, pois os desenvolvedores não precisam aprender e integrar múltiplas ferramentas para diferentes tipos de processamento. A consistência da API em várias linguagens (Scala, Java, Python, R) também contribui para sua popularidade.

⚡ 10 mitos sobre Apache Spark e Big Data

🧱 Spark é só para empresas gigantes

Você pode usar Spark em pequenos clusters e projetos médios com eficiência e escalabilidade sob demanda.

💽 Spark é só para dados estruturados

Você processa dados estruturados, semi e não estruturados — Spark é versátil e adaptável.

👨💻 Precisa ser expert em Scala para usar

Você programa com Spark em Python, Java, R ou SQL, sem precisar dominar Scala profundamente.

🐘 Spark é apenas uma evolução do Hadoop

Você usa Spark com ou sem Hadoop — ele é independente e muito mais rápido para várias tarefas.

🔍 Spark serve apenas para batch

Você realiza análises em tempo real com Spark Streaming, além de ETL e batch.

💥 Spark resolve qualquer gargalo de dados

Você precisa conhecer limitações, como uso de memória, paralelismo mal distribuído e shuffle pesado.

💻 Spark roda mal em computadores locais

Você testa e desenvolve localmente com o modo standalone antes de escalar para o cluster.

🧩 Spark substitui todas as ferramentas de dados

Você integra Spark com Hive, Kafka, Cassandra, Delta Lake e outras, mas ele não elimina tudo.

📉 Spark não é útil para BI

Você combina Spark com ferramentas de BI para fornecer dados processados em tempo real ou por lotes.

🎯 Spark é sempre mais rápido que tudo

Você pode ter desempenho inferior se usar mal as APIs ou não entender a arquitetura.

🔥 10 verdades elucidadas sobre Spark e Big Data

⚙️ Spark é orientado a paralelismo eficiente

Você divide grandes volumes de dados entre nós para processar tudo simultaneamente com menos tempo.

🧠 In-memory é o diferencial do Spark

Você ganha velocidade porque os dados são mantidos na memória, evitando I/O intensivo como no Hadoop.

🔄 RDDs e DataFrames são abstrações poderosas

Você manipula dados com flexibilidade e desempenho, escolhendo a melhor API para o seu caso.

💬 Suporte a múltiplas linguagens facilita a adoção

Você programa em Python (PySpark), Java, Scala, R e até SQL — o acesso é democrático.

🚀 Spark é altamente escalável

Você escala horizontalmente em clusters, aumentando nós conforme o crescimento dos dados.

📊 Spark Streaming permite análise em tempo real

Você processa eventos contínuos de forma distribuída, útil para logs, sensores e métricas.

📁 Spark facilita pipelines de ETL complexos

Você transforma, limpa e prepara dados em grande escala com fluidez entre os módulos.

🔗 Spark se conecta bem com ferramentas do ecossistema

Você integra com bancos NoSQL, filas de mensagens e sistemas distribuídos facilmente.

📈 Spark MLlib oferece machine learning distribuído

Você treina modelos em grandes conjuntos de dados sem se preocupar com limites de memória.

🔒 Spark possui camadas de segurança integráveis

Você protege dados com autenticação, criptografia e controle de acesso via Hadoop, Kubernetes ou serviços gerenciados.

📡 Margens de 10 projeções de soluções

🔁 Utilize DataFrames para otimizações automáticas

Você se beneficia do Catalyst Optimizer ao usar DataFrames, reduzindo tempo de execução.

🔀 Organize partições manualmente em grandes jobs

Você evita shuffle pesado ao gerenciar bem a distribuição de dados entre os nós.

📦 Prefira operações lazy e transformações encadeadas

Você ganha performance ao deixar o Spark otimizar execuções com base no DAG final.

💾 Use persistência seletiva com .persist() ou .cache()

Você mantém dados relevantes em memória e evita recomputações desnecessárias.

🧪 Teste localmente com modo standalone antes de escalar

Você ajusta e depura seu código sem precisar de cluster completo.

🎯 Combine Spark com Kafka para ingestão em tempo real

Você lê dados de streams contínuos para processar em tempo real de forma escalável.

📊 Use Delta Lake para controle de versões e transações

Você ganha confiabilidade com ACID em tabelas sobre o Spark.

📚 Documente e modularize pipelines Spark

Você facilita manutenção e entendimento ao separar tarefas em funções reutilizáveis.

🚨 Monitore com Spark UI e ferramentas externas

Você identifica gargalos e falhas acompanhando a execução dos jobs visualmente.

💬 Treine sua equipe em boas práticas com PySpark

Você ganha produtividade e evita retrabalho ao ensinar modelagem e sintaxe eficientes.

📜 10 mandamentos de Apache Spark e Big Data

⚡ Entenderás o funcionamento do DAG antes de executar

Você analisará como o Spark monta o grafo de execução para planejar suas transformações.

🧱 Escolherás a API ideal para cada tarefa

Você usará RDDs para controle e DataFrames para performance, conforme a complexidade.

🧠 Cachearás com sabedoria

Você só guardará na memória o que realmente for reaproveitado e custoso de recalcular.

📏 Ajustarás partições conforme o volume de dados

Você não deixará partições desequilibradas, pois isso prejudica a paralelização eficiente.

🔍 Evitarás wide transformations excessivas

Você reduzirá joins e shuffles sempre que possível para melhorar a performance.

📡 Utilizarás fontes e sinks compatíveis e otimizadas

Você escolherá conexões rápidas e tolerantes a falhas para integração com bancos ou streams.

📈 Monitorarás a execução em tempo real

Você acompanhará jobs, estágios e tarefas para identificar travamentos e desperdícios.

📚 Treinarás continuamente sua equipe em Spark

Você atualizará conhecimentos com práticas novas e recursos que surgem com cada versão.

🔄 Atualizarás o cluster com versões seguras e otimizadas

Você manterá o Spark em versões recentes para explorar melhorias de performance e segurança.

🌍 Promoverás escalabilidade consciente

Você escalará com propósito, controlando custos e recursos para não desperdiçar infraestrutura.

4. Aplicações e Casos de Uso

A versatilidade e o desempenho do Apache Spark o tornaram a escolha preferida para uma ampla gama de aplicações de Big Data:

ETL (Extract, Transform, Load): O Spark é amplamente utilizado para processar, limpar e transformar grandes volumes de dados brutos de diversas fontes (Data Lakes) em formatos estruturados para análise (Data Warehouses ou Data Marts). Sua capacidade de lidar com dados estruturados, semiestruturados e não estruturados o torna ideal para essa finalidade.

Machine Learning em Escala: Com o MLlib, o Spark permite que cientistas de dados construam e treinem modelos de Machine Learning em conjuntos de dados que não cabem em uma única máquina. Isso inclui desde sistemas de recomendação para e-commerce até detecção de fraudes em transações financeiras.

Análise de Dados em Tempo Real (Real-time Analytics): O Spark Streaming é usado para processar fluxos contínuos de dados de sensores IoT, logs de servidores, cliques em websites e feeds de mídias sociais para detecção de anomalias, monitoramento de saúde de sistemas ou personalização em tempo real.

Business Intelligence e Relatórios Ad Hoc: Com o Spark SQL e DataFrames, analistas de dados podem executar consultas complexas e gerar relatórios em grandes volumes de dados de forma interativa, acelerando o processo de tomada de decisão.

Processamento de Grafos: O GraphX permite a análise de redes complexas, como redes sociais para identificação de influenciadores, redes de comunicação para detecção de atividades maliciosas, ou grafos de conhecimento.

Processamento de Linguagem Natural (PNL): Embora não seja uma biblioteca nativa, o Spark pode ser usado para pré-processar grandes volumes de texto e, em conjunto com bibliotecas de PNL, realizar análises de sentimento, classificação de texto e extração de informações em escala.

Genômica e Bioinformática: O Spark é usado para processar e analisar grandes conjuntos de dados genômicos, como sequências de DNA, para identificar variantes genéticas associadas a doenças ou para pesquisas em medicina personalizada.

Internet das Coisas (IoT): Ingestão e processamento de dados de milhões de dispositivos IoT para monitoramento preditivo, otimização de operações e criação de cidades inteligentes.

5. Desafios e Considerações na Utilização do Spark

Apesar de suas inúmeras vantagens, a implantação e o gerenciamento do Apache Spark podem apresentar desafios:

Gerenciamento de Recursos: O Spark é intensivo em recursos, especialmente memória. Gerenciar a alocação de recursos em um cluster e otimizar as configurações para evitar estouros de memória e garantir o desempenho ideal é crucial.

Otimização de Desempenho: Embora o Spark seja rápido, a escrita de código não otimizado ou a má compreensão de como as transformações e ações operam podem levar a gargalos de desempenho (ex: shuffles excessivos, coletas de RDDs muito grandes para o driver).

Complexidade da Governança de Dados: Lidar com grandes volumes de dados em um ecossistema distribuído exige estratégias robustas de governança de dados, qualidade de dados e segurança.

Curva de Aprendizagem: Embora a API do Spark seja mais amigável que o MapReduce, ainda exige um bom entendimento de programação distribuída e conceitos de Big Data.

Debugging: Depurar aplicações Spark em um ambiente distribuído pode ser mais complexo do que em sistemas monolíticos.

Escolha do Formato de Dados: A escolha de formatos de dados otimizados para Spark (ex: Parquet, ORC) é fundamental para o desempenho, mas a migração de dados existentes pode ser um desafio.

Custo de Infraestrutura: Embora seja de código aberto, a infraestrutura necessária para rodar grandes clusters Spark pode ser cara, especialmente em ambientes on-premise. Soluções em nuvem (AWS EMR, Azure Databricks, Google Cloud Dataproc) ajudam a mitigar isso, mas introduzem custos de serviço gerenciado.

6. Perspectivas Futuras e Evolução

O ecossistema Apache Spark continua a evoluir rapidamente, com foco em:

Inteligência Artificial e Machine Learning: Integração mais profunda com frameworks de Deep Learning (TensorFlow, PyTorch) através de conectores e otimizações. O Spark será cada vez mais uma plataforma para MLOps (Machine Learning Operations) em escala.

Databricks e Lakehouse Architecture: A empresa Databricks (criadora do Spark) promove ativamente a arquitetura "Lakehouse", que combina os benefícios de Data Lakes (flexibilidade, baixo custo) com os de Data Warehouses (estrutura, performance, governança), com o Spark como motor central.

Streaming Unificado: Melhorias no Spark Streaming para lidar com latências ainda menores e cenários mais complexos de processamento de eventos. O Structured Streaming, que trata fluxos de dados como tabelas em constante crescimento, simplifica a programação de streaming.

Melhorias de Desempenho: Otimizações contínuas no Catalyst Optimizer e no motor Tungsten para ainda maior eficiência e velocidade, especialmente para cargas de trabalho de SQL.

Facilidade de Uso e Acessibilidade: Ferramentas e interfaces mais amigáveis para desenvolvedores e analistas não especializados em Big Data, como o Databricks SQL.

Integração com Ferramentas de Nuvem: Aprofundamento da integração com os serviços de Big Data e IA dos principais provedores de nuvem (AWS, Azure, Google Cloud).

Computação Serverless: A capacidade de executar cargas de trabalho Spark sem a necessidade de gerenciar explicitamente servidores, com recursos sendo alocados sob demanda.

7. Conclusão

O Apache Spark consolidou sua posição como uma das ferramentas mais importantes e versáteis para o processamento de grandes volumes de dados. Sua arquitetura inovadora, que prioriza o processamento em memória e oferece um modelo de programação unificado para diversas cargas de trabalho, o distingue de gerações anteriores de frameworks de Big Data. Desde o ETL e a análise batch até o processamento de streaming em tempo real, machine learning escalável e análise de grafos, o Spark oferece uma solução abrangente para extrair valor de dados em uma escala sem precedentes.

Referências (Exemplos - Você precisará pesquisar e adicionar referências reais e atuais)

[1] Zaharia, M., Chowdhury, M., Franklin, M. J., Shenker, S., & Stoica, I. (2012). Spark: Cluster Computing with Working Sets. Proceedings of the 2nd USENIX Conference on Hot Topics in Cloud Computing (HotCloud).

[2] Karau, H., Konwinski, A., Wendell, P., & Zaharia, M. (2015). Learning Spark: Lightning-Fast Big Data Analysis. O'Reilly Media.

[3] Armbrust, M., et al. (2015). Spark SQL: Relational Data Processing in Spark. Proceedings of the 2015 ACM SIGMOD International Conference on Management of Data, 1383-1394.

[4] Zaharia, M., Das, T., Li, H., Ma, T., Mcauley, R. J., & Chowdhury, M. (2016). Apache Spark: A Unified Engine for Big Data Processing. Communications of the ACM, 59(11), 56-65.

[5] Databricks. (2025). What is Apache Spark? Recuperado de [Exemplo de link: